今日,阶跃星辰宣布其新一代基础大模型Step 式开源,并在其开放平台上提供API服务。用户可访问平台(platform.stepfun.com)、官方网站(stepfun.com)或APP体验Step 基础大模型功能。

众所周知,Step 是一个多模态能力的核心,其设计着眼于“轻量视觉路径”与“稳定协同训练”的多方面考虑。为了解决视觉引入带来的token负担和训练干扰问题,它采用了规模的Vision Encoder,并通过双层卷积对视觉特征进行降采样处理。这一措施显著减少了视觉token的数量,达到了原来的从而有效减轻了上下文长度的压力,提升了推理效率。

xiayx附官方对 Step 3 模型的介绍如下:

核心要点

步骤兼顾智能化与高效性,专门为追求性能与成本平衡的公司和开发者量身定做,旨在为未来推理时代提供最佳解决方案。

Step 3 采用 MoE 架构,总参数量 321B,激活参数量 38B。

在这一阶段,系统具备卓越的视觉感知能力和复杂的推理能力,能够精确地处理跨越不同领域的情境理解、数学与图像数据的综合分析,并应对日常生活中各种涉及视觉的问题。

通过 MFA(Multi-matrix Factorization Attention) & AFD(Attention-FFN Disaggregation)的优化,在各类芯片上推理效率均大幅提升。

StepMesh 通信库现已开源,适用于 AFD 领域,并提供标准接口和高性能部署解决方案,确保关键性能能在真实场景中稳定实现。

模型限时折扣中,所有请求均按最低价格计算,每百万 token 价格低至输入 1.5 元,输出 4 元。

现在,你可以在我们的开放平台Step API 上线了!只需访问platform.stepfun.com,或直接在App Store下载阶跃AI App进行体验。

行业领先的模型性能

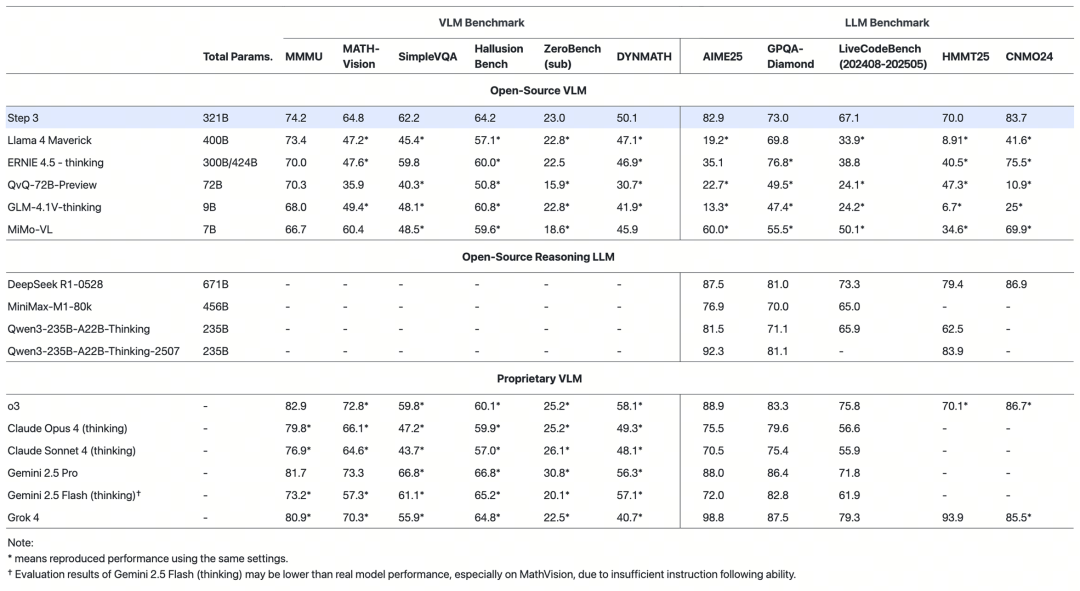

在MMMU、MathVision、SimpleVQA、AIME GPQA-Diamond和LiveCodeBench(至)的测试中,我们对第进行了评估,在同类型开源模型中,其性能表现尤为出色。

技术亮点

在本步骤中,我们着重解决了多模态协同、系统解码成本与推理效率的问题,通过优化训练路径、架构设计和推理部署,实现了全面升级。

- 预训练架构

Step 核心结构采用了自研MFA注意力机制,有效降低了KV缓存开销和算力消耗。在不牺牲模型性能的前提下,这一方案实现了资源利用与推理效率的平衡,使得模型可在B显卡上完成大吞吐量推理,具备真实部署的可行性。

- 多模态预训练

在Step ,多模态能力聚焦于“轻量视觉路径”与“稳定协同训练”。通过采用的视觉编码器并借助双层卷积对特征进行降采样处理,将视觉token数量减少至原本的一半,有效地减轻了上下文长度的压力。此方法显著提升了模型的推理效率和整体性能。

确保多模态模型训练的稳定性至关重要。为了达到这一目标,我们将训练过程分为两个阶段:在第一阶段,通过强化Encoder感知来优化整体模型;随后,在第二阶段中,仅对主干和连接层进行微调以减少梯度干扰。为保证稳定协同,需要精心选择训练策略,并清洗多模态语料。这些步骤包括引入相似度过滤、重采样以及任务比例控制等技术手段,从而提升图文协同质量并增强模型的鲁棒性。

- AFD 解耦系统

Step 在系统架构层重构了解码流程,重点解决 Attention 与 FFN 混合执行带来的推理瓶颈以及资源不匹配问题。为此,我们实现了高性能的 AFD(Attention-FFN Disaggregation)方案,将两类计算任务解耦成为两个子系统,并通过多级流水线并行调度,有效提升整体吞吐效率。

得益于解耦后的子系统对数据传输的高度要求,我们在开发过程中专门研发了StepMesh通信库,基于GPU Direct RDMA技术实现了跨卡的低延迟和高带宽传输。此外,该库还具备不占用GPU计算资源、兼容多种异构硬件等优点。在s的解码SLA标准下,StepHopper GPU上的吞吐量达到token/gpu/s,显著高于类似条件下DeepSeek Vtoken/gpu/s性能。此外,在特定硬件和长文场景中,该性能增益可达。

全新版本的StepMesh库已经与模型一起对外开放,为实现跨硬件的标准部署提供了强大的工具链。这种标准设计确保了关键性能指标的持续可靠性,同时也使这些功能能够轻松地集成到各种服务中。未来,我们计划与开源社区进一步合作,共同推广这一技术,使它更广泛和更容易被采纳和使用。

- 标签: